機械学習の環境をDIGITSとDockerを使って簡単に整える話

機械学習が何をやっているのか全くわかっていなくても 簡単に画像処理の機械学習を行える環境を整えた話。

この記事の目標は、何もわからなくてもとりあえず画像を機械に学習させる、です。 (細かい部分が全くわからないことの言い訳)

今回は、Digitsという、NVIDIAが作っている Caffeという機械学習ライブラリのWebアプリを使ってみる。 また、めんどくさい導入部分を全部Dockerにやってもらう。

事前準備

- docker-machine導入済み

- docker-compose導入済み

docker-machineでdefaultという名前のマシンを作ってある前提で進めます。

docker-machineってなんだよって人は 公式ドキュメントのDocker Machineの項目を 読めばいいと思う。

Digitsが動いているコンテナを立てるまで

以下のdocker-compose.ymlファイルを適当なディレクトリに配置し、

同じ階層でdocker-compose up -dを実行する。以上。

実行が終わったらdocker-machine env defaultコマンドで出てくるIPに

ポート5000でアクセスすればWebアプリが動いているのが確認できるはず。

これだけで画像の学習させる環境ができちゃう。便利。

# docker-compose.yml

digits:

image:

kaixhin/digits

ports:

- "5000:5000"

volumes:

- ./images/:/mnt/volumes/images

Docker HubにDigitsのコンテナイメージが あったので、ありがたく使わせて頂いた。

コマンドを実行した時に作られるimagesディレクトリは、

後で学習する画像ファイルを設置する場所になるのでそのままにしておく。

もし作成されてなかったら、imagesディレクトリを作成してから

もう一回docker-compose up -d。

学習させてみる

とりあえず、右上の「ログイン」ボタンからログインしておく。 出てきたフォームに適当に名前を入れるだけでOK。

データセットの作成

学習させるためには、データセットが必要なのでまずはそれの作成から。

自動で作成されたimagesの中に、学習させたい画像をディレクトリ毎にわけて設置する。

例としてオクスフォード大学で公開されている

ペット画像のデータセットを使ってみる。

上記リンク先の「Dataset」から、圧縮されたペット画像をダウンロードして展開。

展開すると、images/ディレクトリとその下に37種類のペットの画像ができるはず。

展開された画像を、以下のようなディレクトリ構造になるように配置する。

ちなみに、全種類の動物を使うと非常に重いので、 お試しの人は、3、4種類ぐらいを配置すればいいと思う。

docker-compose.yml images ├── Abyssinian │ ├── Abyssinian_1.jpg │ ├── Abyssinian_2.jpg │ ├── Abyssinian_3.jpg ~ ~ ~ │ ├── Abyssinian_197.jpg │ ├── Abyssinian_198.jpg │ └── Abyssinian_199.jpg ├── Bengal │ ├── Bengal_1.jpg │ ├── Bengal_2.jpg │ ├── Bengal_3.jpg ~ ~ ~ │ ├── Bengal_197.jpg │ ├── Bengal_198.jpg │ └── Bengal_199.jpg

こうすることで、それぞれのペットの画像がディレクトリ名の

AbyssinianやBengalといったラベルごとに分類されることになる。

次に、分類した画像からCaffeに流し込むためのデータセットを作成する。

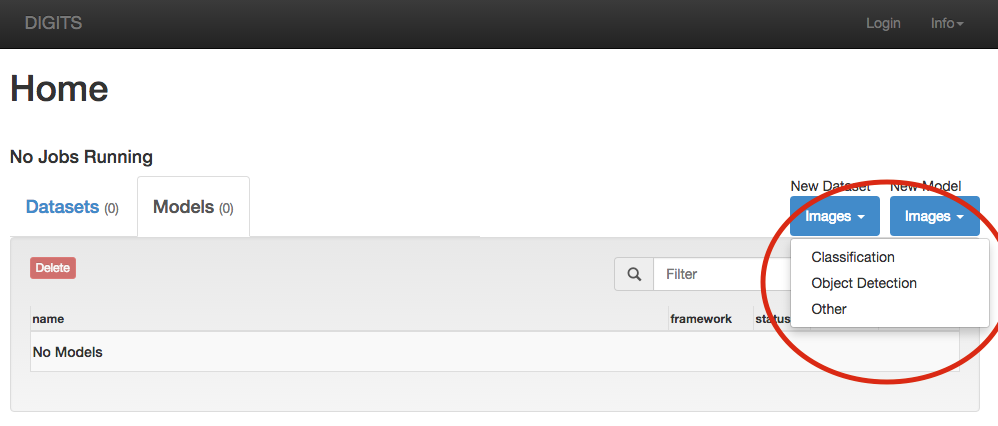

下の画像のように、「New Dataset」の「Images」から、「Classification」を選択。

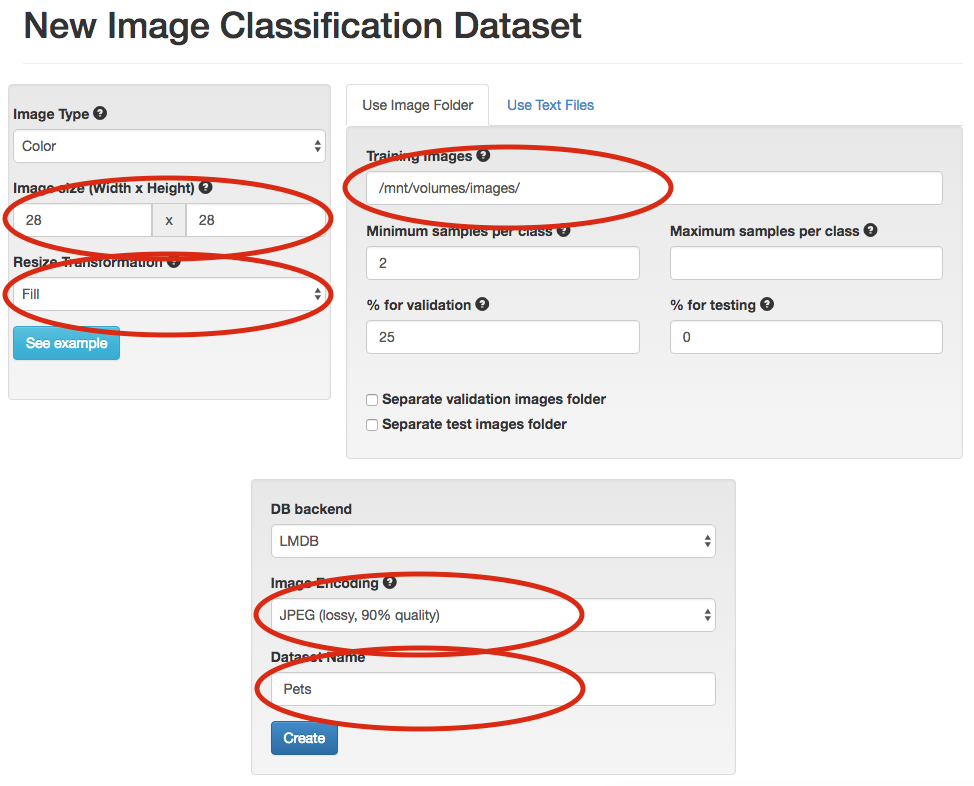

「New Image Classification Dataset」というページに飛んだら、 下図の赤丸の部分を同じように編集する。

編集をしたら、「Create」ボタンをクリック。 クリックしたら別ページに飛んでデータセットが作成され始める。

ダウンロードしたペット画像全部を使っていると ちょっと時間がかかるので少しだけ待つ。 飛ばされたページを定期的に更新すれば、今どれぐらい終わったかがわかる。

終わるまで待ったらデータセットの作成は終了。簡単!

モデルの作成

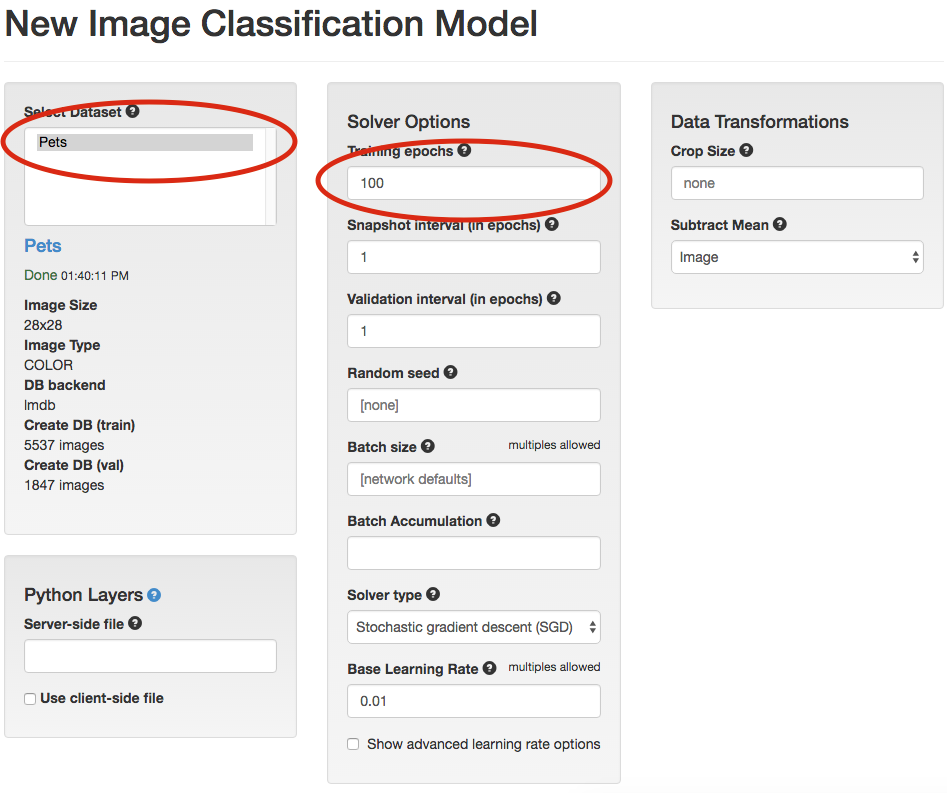

データセットができたら、それを学習したデータモデルを作成する。

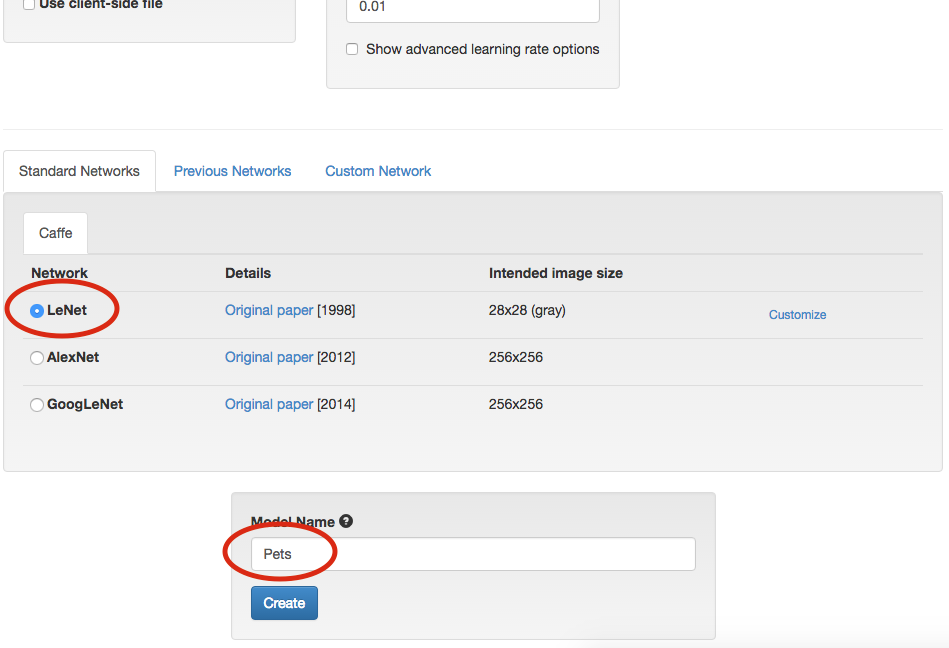

データセットを作成した時の横にある「New Model」から、 同じようにClassificationを選択する。

以下の様な画面が出てくるので、赤丸の部分を同じように設定。 設定が終わったら名前をつけて「Create」をクリック。

クリックすると、また別ページに遷移して学習が始まる。 終わったら学習終了。簡単!

学習結果を試す

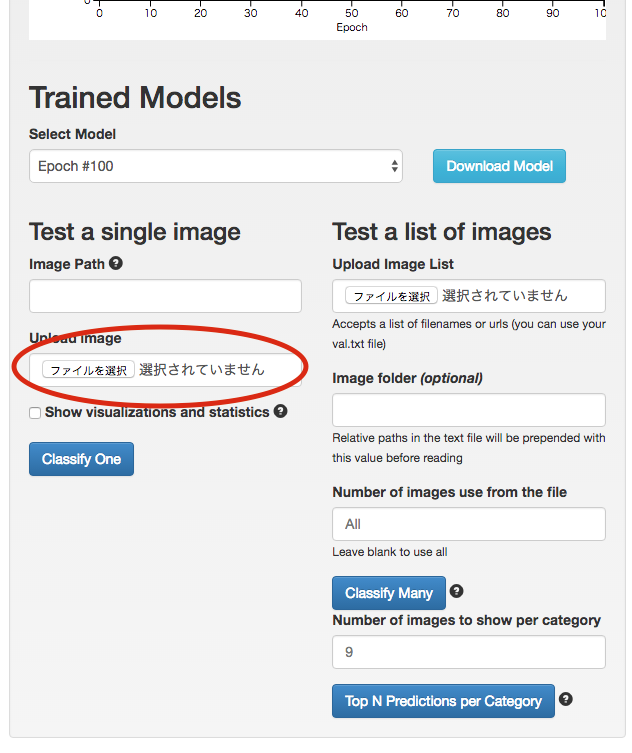

モデルデータを作成する時に飛ばされるページの下部に、下図のようなフォームがある。

図中の「Test a single image」の「Upload image」から識別させたい画像を選択して、 「Classify One」をクリック。

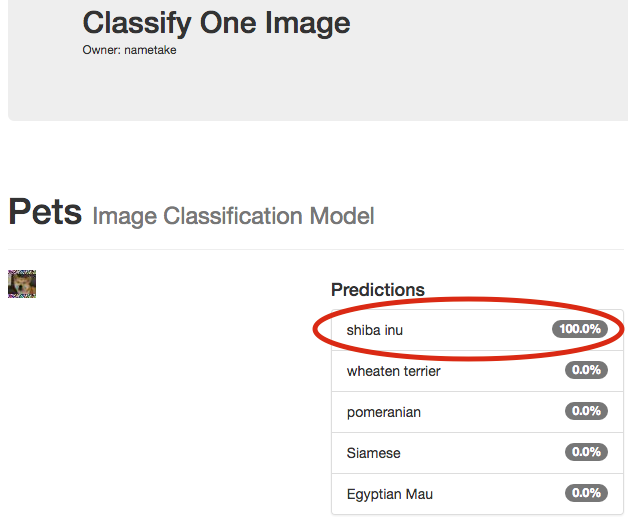

クリックすると別ページが開き、学習させたモデルから選択した画像が何に近いのかを、 教えてくれる。

下図だと柴犬ちゃんがしっかり「shiba inu」と認識されている。すごい。

DigitsのRest API

なんとDigitsではRest APIが実装されている。

使い方はissueに書いてある通り。

コレを使えば割と簡単に学習結果をアプリケーションに反映させられる。